一、该问题的重现步骤是什么?

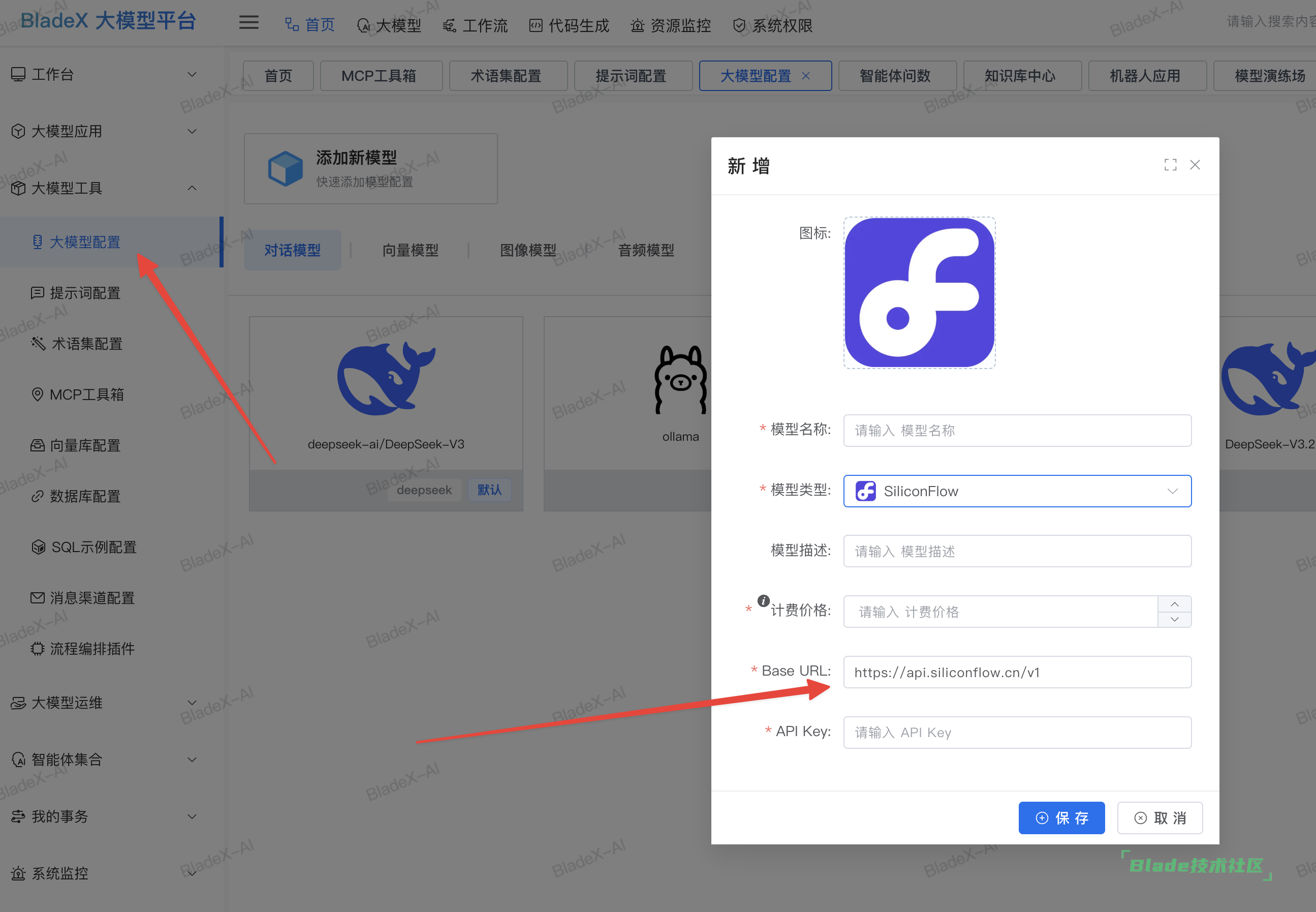

1. 创建大模型配置,配置为内网自建模型,qwen-32b

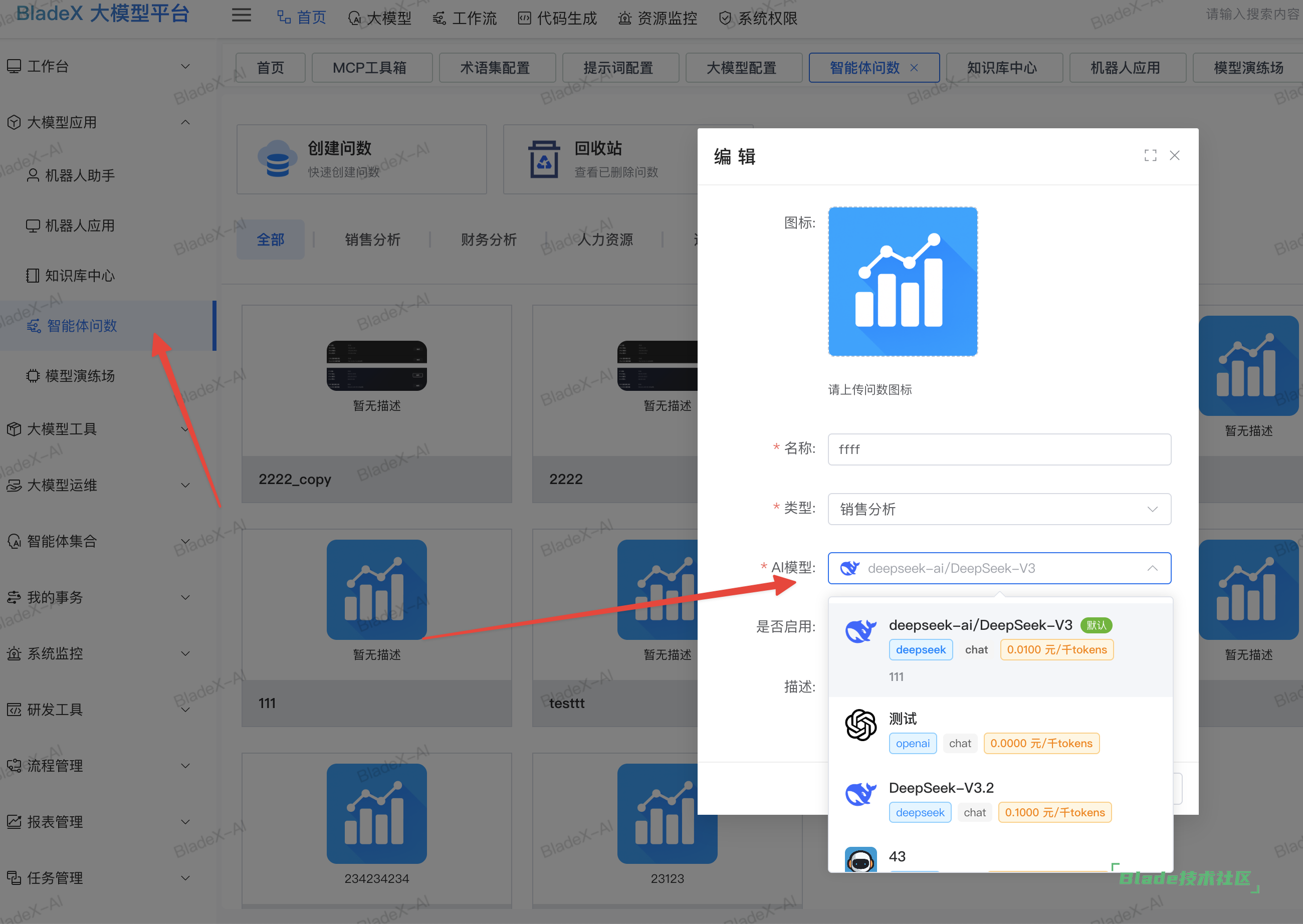

2. 配置一个问数智能体,选择自建的模型

3. 输入问题进行问数

二、你期待的结果是什么?实际看到的又是什么?

期望返回正确图表。实际返回:"SQL生成失败: SQL生成失败

三、你正在使用的是什么产品,什么版本?在什么操作系统上?

我在使用大模型产品,版本是1.3.0。服务器系统是麒麟V10

四、请提供详细的错误堆栈信息,这很重要。

错误堆栈信息见附件日志文件

五、若有更多详细信息,请在下面提供。

在部署到服务器之前,在本地已经适配了达梦数据库,并且用公网Qwen3-Max模型测试了问数的能力,但是部署到服务器之后出现如上问题。

部署在服务器上的自建模型,在模型演练场中是正常的。

附件中包含llm_message数据,我发现在本地和在服务器上模型返回的内容不一样。

部署到服务器的自建模型本地连接测试问数也不正常还是只有部署到服务器的时候不正常?

看下qwen-32b在大模型平台配置的时候,模型类型是不是选择的ollama。

具体要看下你本地启动连接本地模型的情况。公网的qwen3-max是兼容的openai的格式,基本不会有问题,主要可能出问题的点在本地模型的返回结构和接受数据格式的结构上。

还得看下你本地启动连接qwen-32b能不能正常使用,然后再进下一步的判断来看问题出在哪里。

如果你本地可以调试,可以在这里打断点,往下面一层一层看下具体的报错信息是什么,也可以进一步辅助查找原因。

老师还有个问题请教,为什么执行问数的时候会调用: https://api.siliconflow.cn/v1/chat/completions? 私有化部署不支持访问互联网,这块应该如何处理? 这个问题和上面的问题是两个问题,上面的问题是在临时开通了访问api.siliconflow.cn策略后出现的。

创建问数的时候会绑定模型,这个模型对应的就得看具体在大模型配置里配置的地址是多少。

如果你配置的是本地,但是调用的是外网,那得给个重现步骤,看看怎么配置才会出现这种效果,然后我们按照你的重现步骤去进行复现和排查。

麻烦把你们服务器上部署的qwen-32b临时开放下外网,然后把地址账号等信息发我们邮件,我们明天安排技术来排查 。bladejava@qq.com

老师,这个模型服务不允许暴露出公网,只能通过跳板机去连接。能否让技术老师远程操作我们的电脑,再连接到跳板机上看下原因?

扫一扫访问 Blade技术社区 移动端